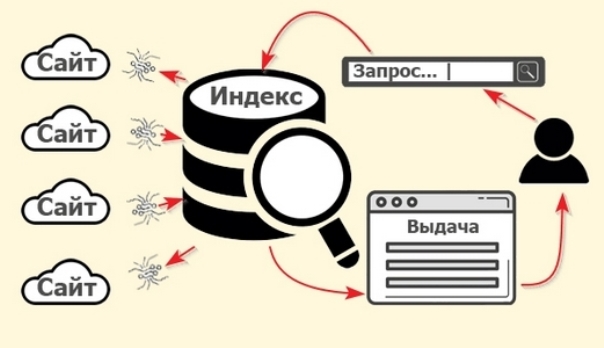

Созданный сайт подобен написанной книге, лежащей высоко на полке библиотеки, куда не дотянется ни посетитель, ни сам библиотекарь. Чтобы ресурс отображался в поисковой системе, необходима индексация в базе данных – сообщение поисковым системам о тематике и созданном контенте.

Как работают боты

Когда мы вбиваем запрос в поисковую строку, роботы ведут нас по уже собранной поисковым ботом базе данных. ВЕБ-ПАУК, или «Краулер» — специальная программа, сканирующая веб-ресурсы. Бот заходит на страничку, рассматривает тексты и картинки, видео, а также выделяет ссылки и движется по ним дальше. Обходя сайт по ссылкам, бот собирает данные, передавая их в базу данных.

Предварительно информация анализируется и обрабатывается. Так как поисковые системы работают на основе математического алгоритма, то Краулер составляет специальную табличку – разбирает текст по словам и составляет перечень слов и количество их включений в текст. Плотность слова принято изменять в процентах. Процент плотности слова — количество упоминаний данного слова, деленное на количество слов. Система хранит не только ссылки, но частотные таблицы поисковых страничек. Слова с наибольшей плотностью создают тематику сайта для представления по запросам пользователей. Этот же принцип используется и в сео анализе сайтов.

Для передвижения веб-паука по ресурсу нужно упростить маршрут передвижения, создав стройную систему ссылок.

Для этого нужно:

- Проверить состояние файла robots.txt.

- Добавить индексную xml карту сайта.

- Сделать хотя бы минимальное наполнение сайта контентом.

Способы поставить сайт на очередь на индексацию

А чтобы бот вообще попал на ваш новоиспеченный ресурс, ему нужно дать «наводку» — перво-определяющую ссылку, по которой он придет на ваш сайт. Эту задачу можно выполнить несколькими способами.

- С помощью страницы типа «add url», помогающей вебмастеру поставить сайт в очередь на индексацию. Для этого нужно зарегистрироваться, ввести капчу и адрес сайта. Процедура проводится по всем поисковым системам. После индексации на сайт уже пойдет немного трафика. На весь процесс может понадобиться от одной до нескольких недель. Индексация может затянуться, если домен уже имеет не совсем хорошую историю.

- Какое-то количество заинтересованных пользователей могут принести сервисы социальных закладок. Специальными инструментами можно разместить сразу несколько десятков закладок за определенный период времени.

Эти два способа представляют верный, но очень медленный способ индексации страниц.

Как ускорить процесс

А чтобы бот быстрее попал на ваш новоиспеченный ресурс, ему нужно дать «наводку» — перво-определяющую ссылку, по которой он придет на ваш сайт. Эту задачу можно выполнить несколькими способами.

Ссылки – временные и вечные

Раз в 1-3 недели роботы проверяют контент уже проиндексированных сайтов, переходя по предоставленным в нем ссылкам (кроме запрещенных атрибутом «роботс»). Если разместить на этих сайтах ссылку на ваш ресурс, боты могут быстро перейти по ней и попасть на ваш сайт, приведя его в базы данных. Лучше всего выбрать те сайты, которые постоянно обновляются: популярные блоги, СМИ, крупные порталы. Желательно выбирать схожую тематику. На свой ресурс можно привлечь двумя способами:

- Временная ссылка на главной странице сайта.

- Вечная ссылка в новом контенте. Стоимость таких ссылок выше, но и передача веса трастового сайта повысит ранжирование и ускорит индексацию.

Социальные сети

Это самый простой способ — Twitter, YouTube, Facebook довольно часто индексируются поисковиками. Если робот переходи по ссылкам из соцсетей (СММ продвижение), сайт получает большой вес от авторитетного ресурса.

Нужно учесть, что в ВК используется редирект, и перехода робота можно ждать намного дольше.

Таким образом, если до старта остается немного времени, сделайте ссылки с социальных сетей – например, с группы или тематического сообщества, и уже в первые дни своего существования можно получить конверсию. При этом сам сайт уже должен быть наполненным полезной информацией, чтобы пользователи сочли его интересным.

Как сделать некоторые страницы невидимыми

Для этого их нужно исключить из поиска с помощью корневого файла robots.txt. Часто закрываются от индексации файлы с личной информацией, корпоративные данные информация о пользователях, счета, договора, любая конфиденциальная информация. Также рекомендуется закрыть страницы дубликаты. Проверить правильность настройки файла можно через Яндекс.Вебмастер – для этого нужно скопировать данные и вставить их в форму, идли загрузить через оригинальный интерфейс.

Центр Медиа Технологий в СПб изготавливает сайты таким образом, чтобы процесс индексации проходил максимально быстро и лояльно со стороны поисковых систем!